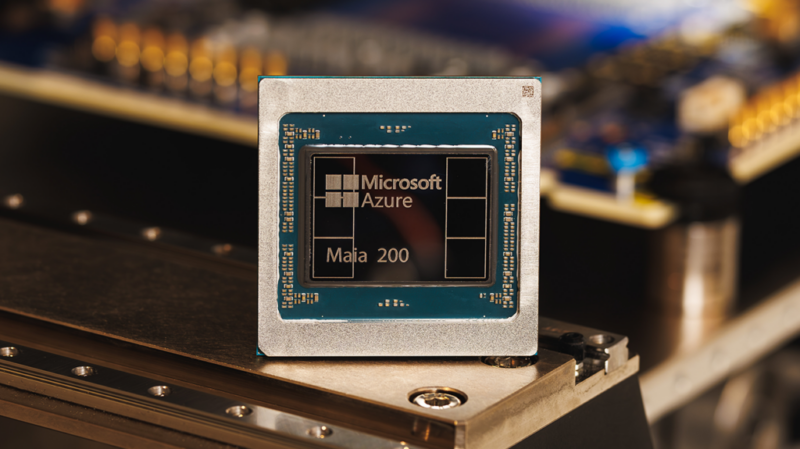

Microsoft lanzó su chip Maia 200: un acelerador de IA en la era del razonamiento

Microsoft no quiere depender de terceros en la competitiva carrera en el mercado de la inteligencia artificial. La compañía ha presentado el Maia 200, su nuevo chip acelerador de IA, diseñado específicamente para la era del razonamiento de las máquinas.

Este chip es un acelerador de inferencia está diseñado para mejorar drásticamente la economía de la generación de tokens con IA. Maia 200, prometiendo ser el silicio de primera mano más eficiente que cualquier otro hiperescalador del mercado.

Maia 200 está construido sobre el proceso de 3nm de TSMC con núcleos tensoriales nativos FP8/FP4, un sistema de memoria rediseñado con 216GB HBM3e a 7 TB/s y 272MB de SRAM integrada, además de motores de movimiento de datos que mantienen los modelos masivos alimentados, rápidos y altamente utilizados.

La compañía destaca que este también es el sistema de inferencia más eficiente creado por Microsoft, con un 30% de rendimiento por dólar superior al hardware de última generación. De acuerdo con una publicación de blog firmada por Scott Guthrie, Vicepresidente Ejecutivo de Nube + IA de Microsoft, este chip ofrece tres veces el rendimiento FP4 del Amazon Train de tercera generación y un rendimiento FP8 superior al TPU de séptima generación de Google.

Microsoft enfoca esfuerzos en mejorar la inferencia de IA

De acuerdo con la información oficial, cada chip Maia 200 contiene más de 140 mil millones de transistores y está adaptado para cargas de trabajo de IA a gran escala, además de ofrecer un rendimiento eficiente por dólar.

En ambos aspectos es capaz de ejecutar con “capacidad de sobra” modelos más recientes que utilizan computación de baja precisión, incluyendo GPT 5.2 de OpenAI. Con cada chip Maia 200 entregando más de 10 petaFLOPS en precisión de 4 bits (FP4) y más de 5 petaFLOPS de rendimiento de 8 bits (FP8) dentro de un envolvente TDP SoC de 750W, la promesa es que este chip logre ejecutar sin esfuerzo los modelos más grandes de la actualidad, así como un buen margen de capacidad para ejecutar modelos aún más grandes que se lancen más adelante.

“Lo crucial es que los FLOPS no son el único ingrediente para una IA más rápida. La alimentación de datos es igualmente importante. Maia 200 ataca este cuello de botella con un subsistema de memoria rediseñado. El subsistema de memoria Maia 200 está centrado en tipos de datos de precisión estrecha, un motor DMA especializado, SRAM integrada en el chip y una estructura NoC especializada para el movimiento de datos de alto ancho de banda, aumentando el rendimiento de los tokens”, explicó Microsoft.

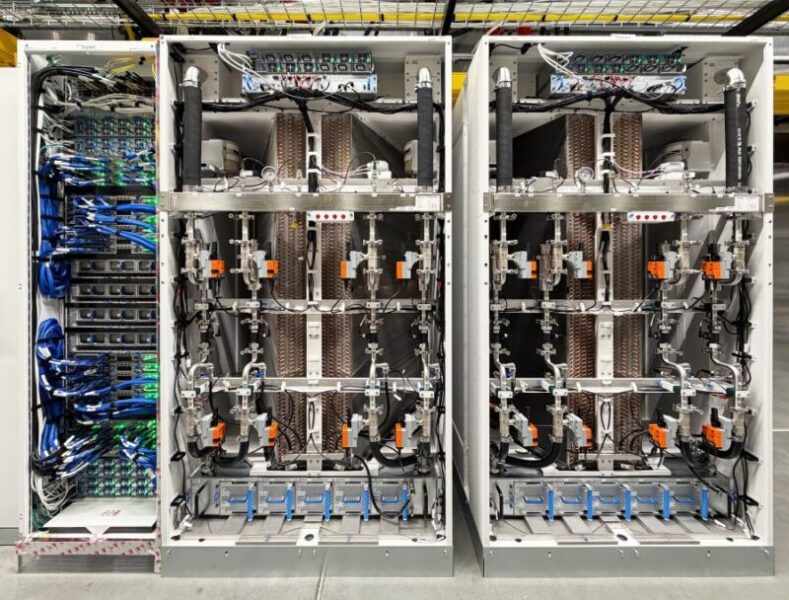

El despliegue inicial del chip Maia 200 ha comenzado a implementarse en centros de datos de la región “US Central” y se espera una expansión progresiva en otras regiones de la infraestructura Azure.

Relacionados